Исключительная роль больших данных уходит в прошлое. Будущее ИИ — это вероятностные модели и обучение на опыте. Исследователи заявляют, что в ближайшие 5 лет компьютеры станут менее «искусственными» и более «интеллектуальными». Они будут меньше полагаться на big data и больше на логические выводы, подобно тому, как человек подходит к проблемам и задачам.

Ограничения больших данных

Сегодня искусственный интеллект развивается при помощи глубокого обучения, используя огромное количество обучающих данных. Например, беспилотные автомобили обучаются на как можно большем количестве данных о разных дорожных ситуациях. Однако есть непредвиденные случаи, которые обучение не может охватить. Автомобиль может хорошо распознавать пешеходов, дорожные знаки, полосы движения, но не справится с детьми в костюмах для Хэллоуина, переходящими дорогу в сумерках.

Функция распознавания лиц iPhone X не работает сразу после утреннего пробуждения, когда лицо опухшее, а взгляд не слишком четкий.

Алгоритмы научились побеждать в шахматы и даже в древние японские го и сеги. Однако стоит повернуть изображение или слегка изменить его, нейросеть запутается и выдаст неправильный ответ.

Информационные системы сталкиваются с деловыми и этическими ограничениями. Не каждая компания имеет необходимый объем данных для создания продуктов с использованием нейронных сетей. Использование огромного количества данных граждан поднимает вопросы конфиденциальности. Работу нейросетей сравнивают с черным ящиком — неясно, как они используют входные данные и как принимают решения. Это также делает их открытыми для манипуляций.

Меньше данных, больше логики

Эксперты полагают, что в будущем нейронные сети станут использовать меньше данных, а мышление компьютера будет более гибким и естественным, как у человека. Компании и стартапы уже работают в этом направлении.

Стартап Vicarious работает над созданием искусственного интеллекта, который сможет обобщать на основе нескольких примеров. Среди инвесторов стартапа — Марк Цукерберг, Джефф Безос и Марк Бениофф. В прошлом году компания разработала алгоритм, который взламывает капчу с точностью 67%, обучившись всего на 5 примерах, в отличие от 200 тысяч, которые требуются современной state-of-the-art модели.

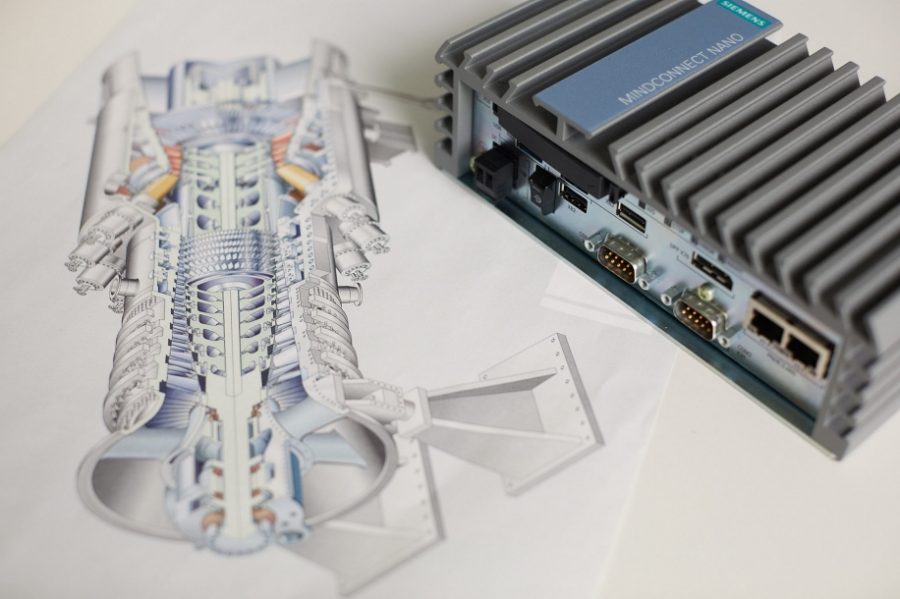

Моделирование того, что человек будет делать в условиях неопределенности и небольшого количества данных, позволило Siemens использовать ИИ для управления сложным процессом горения в газовых турбинах, например, поступления воздуха и газа, контроль температуры внутри и снаружи турбины. Для сбора необходимого количества данных для обучения понадобилось бы больше 100 лет работы турбины.

-

Siemens использует устройство GT-ACO в пилотных операциях для управления большими газовыми турбинами Siemens в США и Южной Корее

Люди могут оценить вероятность события, основываясь даже на небольшом опыте. Ученые моделируют подобные рассуждения для компьютеров, используя Гауссовские методы — вероятностные модели, которые могут работать с неопределенностью, основываясь на небольшом количестве данных. Так компания Alphabet запустила проект Loop. Он предоставляет интернет-соединение через гигантские воздушные шары, парящие в стратосфере. Их навигационные системы используют Гауссовские процессы, чтобы передвигаться в воздушных потоках.

Разработчики пытаются научить ИИ «здравому смыслу»: естественному общению, реакции на непредвиденные ситуации и способности обучаться на опыте. DARPA инвестирует $2 миллиарда в программу Machine Common Sense, а Microsoft разрабатывает алгоритмы, которые могут понимать неоднозначность слов в задачах NLP.

Использование небольшого количества данных для обучения — не новая идея. Такими разработками занимались ученые еще в 1950 годах. Они были отложены в сторону после успеха больших данных. Сегодня появляется все больше возможностей и исследований, которые показывают, что это перспективное направление для развития ИИ.