Итальянские исследователи предложили метод анимации путем переноса движения из видео на целевое изображение. В отличие от предыдущих разработок Motion transfer, подход Monkey-Net не предназначен для конкретных категорий, а эффективен для анимирования любых объектов.

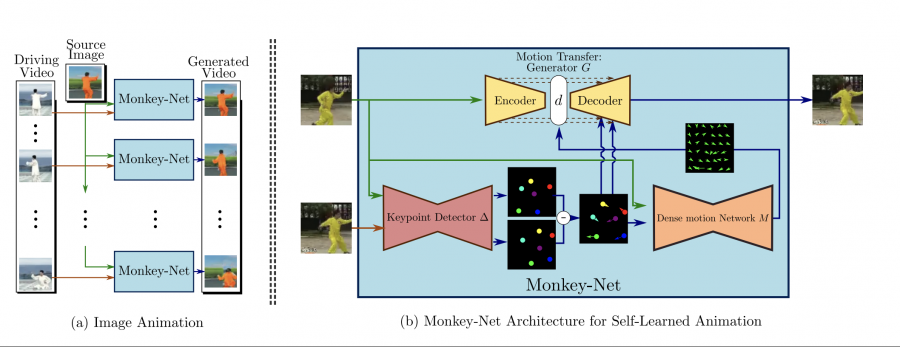

Сеть Monkey-Net обучается без учителя. Для создания анимации ей требуется только входящее видео и изображение, на которое нужно перенести движения. Ключевая особенность разработки заключается в использовании разреженных, ориентированных на движение ключевых точек для моделирования и передачи информации о движении. На целевое изображение переносятся только точки, отвечающие за движения.

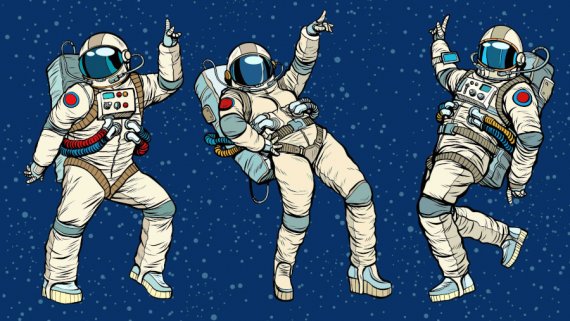

Читайте также: Танцуют все! — невероятное качество Motion Transfer для видео

Архитектура сети состоит из трех основных модулей:

- детектора, который обучается без учителя и извлекает ключевые точки объекта;

- сети прогнозирования Dense Motion для создания тепловых карт и кодирования информации о движении;

- сети передачи движения (Motion Transfer Generator) c архитектурой энкодер-декодер, которая использует тепловые карты движения и входное изображение, чтобы синтезировать выходные кадры.

Результаты работы Monkey-Net

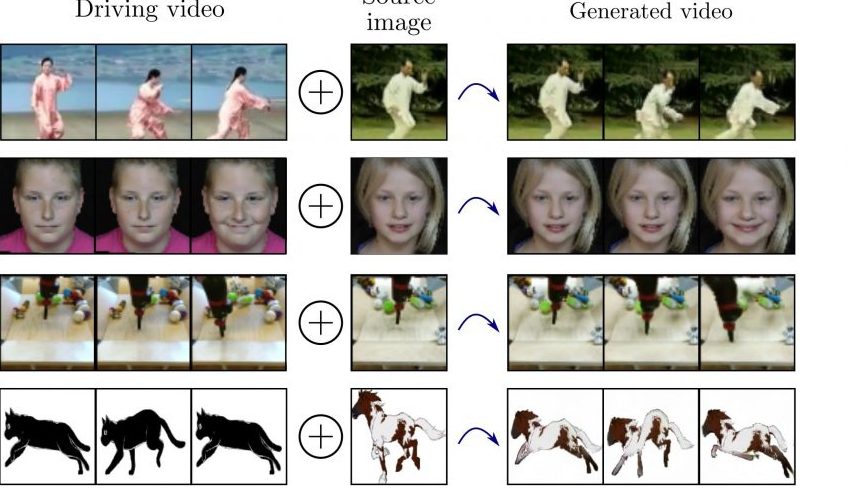

Работу метода протестировали на датасетах Tai-Chi, the BAIR robot pushing, UvA-NEMO Smile и MGIF. Результаты показывают, что предложенный метод анимации изображений позволяет получать качественную анимацию для разных объектов.

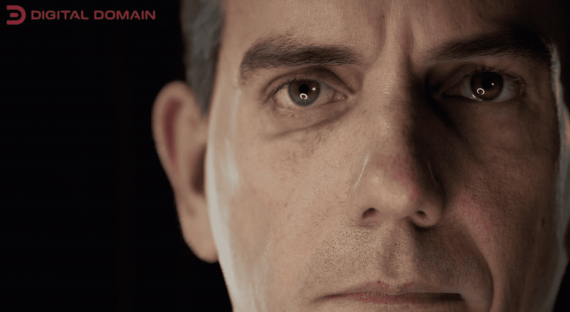

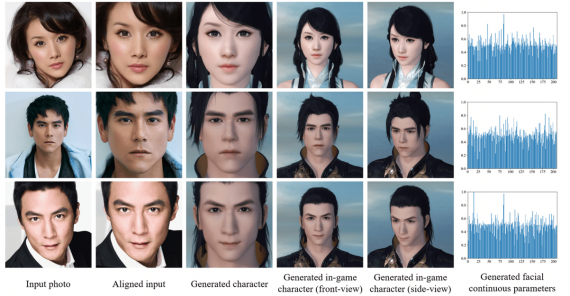

NEMO Face Dataset

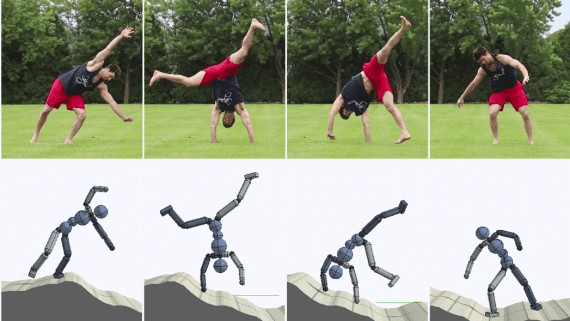

Taichi Dataset

BAIR Robot Dataset

MGIF Dataset

Открытый код доступен на GitHub.