В Google AI разработали новый метод подбора модели обучения с подкреплением. Использование метода сокращает количество моделей для тестирования в реальных экспериментах.

Обучение с подкреплением — это такая группа алгоритмов, в которых агенты учатся принимать решения на основании той среды, в которой находятся, и прошлого опыта. Один из видов обучения с подкреплением — off-policy.

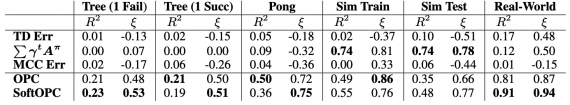

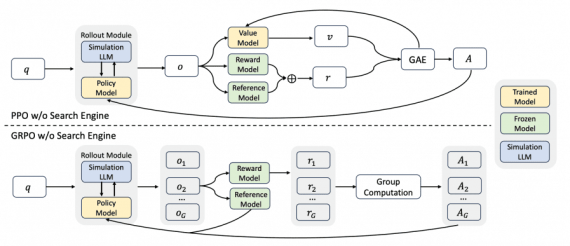

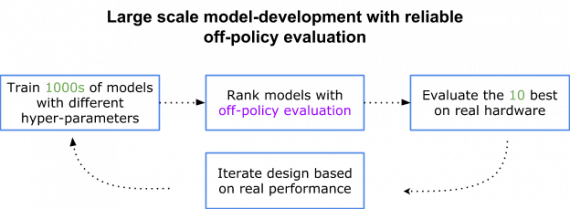

Off-policy обучение с подкреплением основано на том, что агент обучается с использованием данных, собранных другими агентами и собой. Это позволяет агенту обучаться навыкам с большей обобщающей способностью. Полноценное off-policy обучение с подкреплением основано на идее, что агент обучается только на прошлых данных. При использовании полноценного RL несколько моделей обучаются на одном датасете с данными, которые собрали прошлые агенты. Затем, на основе метрики, из моделей выбирается лучшая. Оценка моделей в полноценных off-policy алгоритмах неэффективна в случае с большим количеством агентов. Исследователи предлагают улучшенный способ оценки агентов — Off-Policy Evaluation (OPE).

OPE — это способ оценки новых агентов на основании данных предыдущих агентов. Использование OPE сокращает количество моделей для тестирования в реальных экспериментах.

Как OPC работает

Off-policy оценка основывается на двух допущениях:

- Изменение состояний в итоговой задаче не случайно;

- Агент либо преуспевает, либо ошибается в конце каждой попытки

Второе допущение естественно для таких задач, как подъем объекта и участие в игре. Каждой попытке присваивается бинарный ярлык: успех или поражение. Считается, что если действие эффективное, то оно вероятнее приведет к успеху, и наоборот.

OPC использует Q-функцию, которая оценивает будущую суммарную награду, если агент выберет какое-то действие при текущем состоянии. Агент выбирает действие, которое принесет наибольшую выгоду. В работе исследователи показывают, что поведение агента оценивается по тому, как часто выбираются эффективные действия. В свою очередь, частота выбора эффективных действий зависит от того, насколько функция ошибки верно определяет эффективные и неэффективные действия. Эта точность классификации действий используется как off-policy оценка модели.

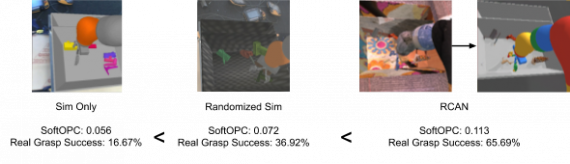

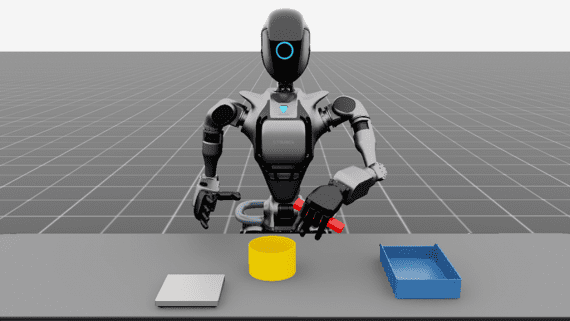

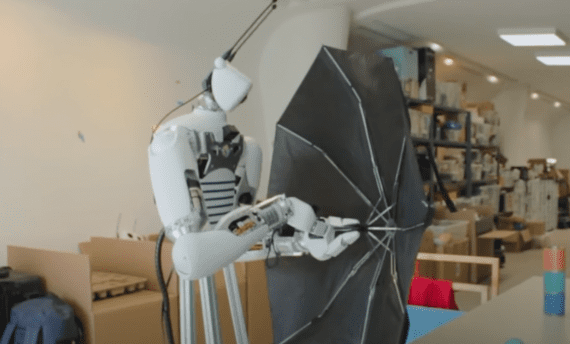

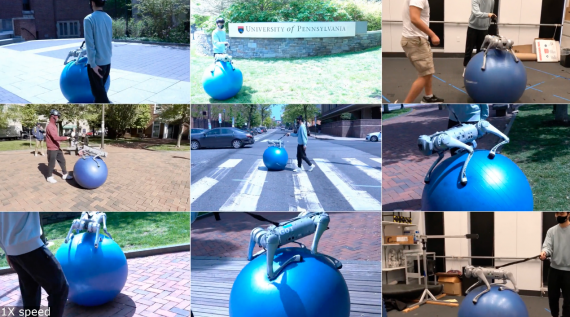

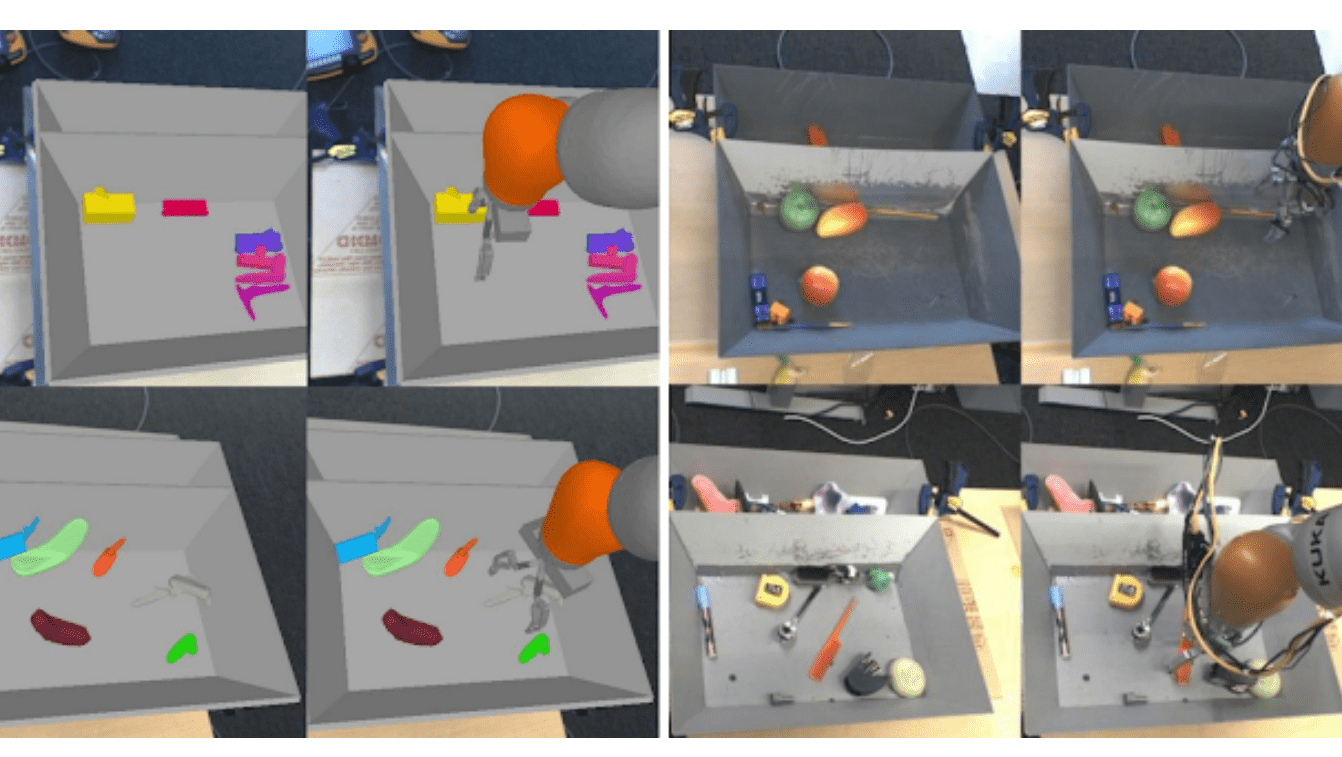

Эксперименты проводились на задаче обучения робота сначала на симуляции, а потом в реальной среде. Результаты показывают, что OPС метрика коррелирует с реальной успешностью алгоритма.