UAR — это метод для оценки устойчивости классификатора к ранее незнакомым состязательным атакам от OpenAI. Функция потерь Unforeseen Attack Robustness оценивает, как нейросеть справляется с искаженными изображениями. Таким образом можно улучшать стабильность предсказаний модели.

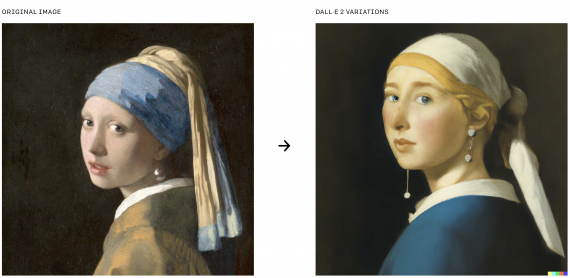

Состязательные атаки — это примеры неверно распознаваемых нейросетью изображений. Важно, что эти примеры — это оригинальное изображение, которое верно распознается нейросетью, с добавлением шума поверх. Наглядный пример — изображение кота нейросеть относит к классу кота с вероятностью выше 90%, а искаженное с помощью шума изображение кота нейросеть относит к неверному классу с высокой вероятностью.

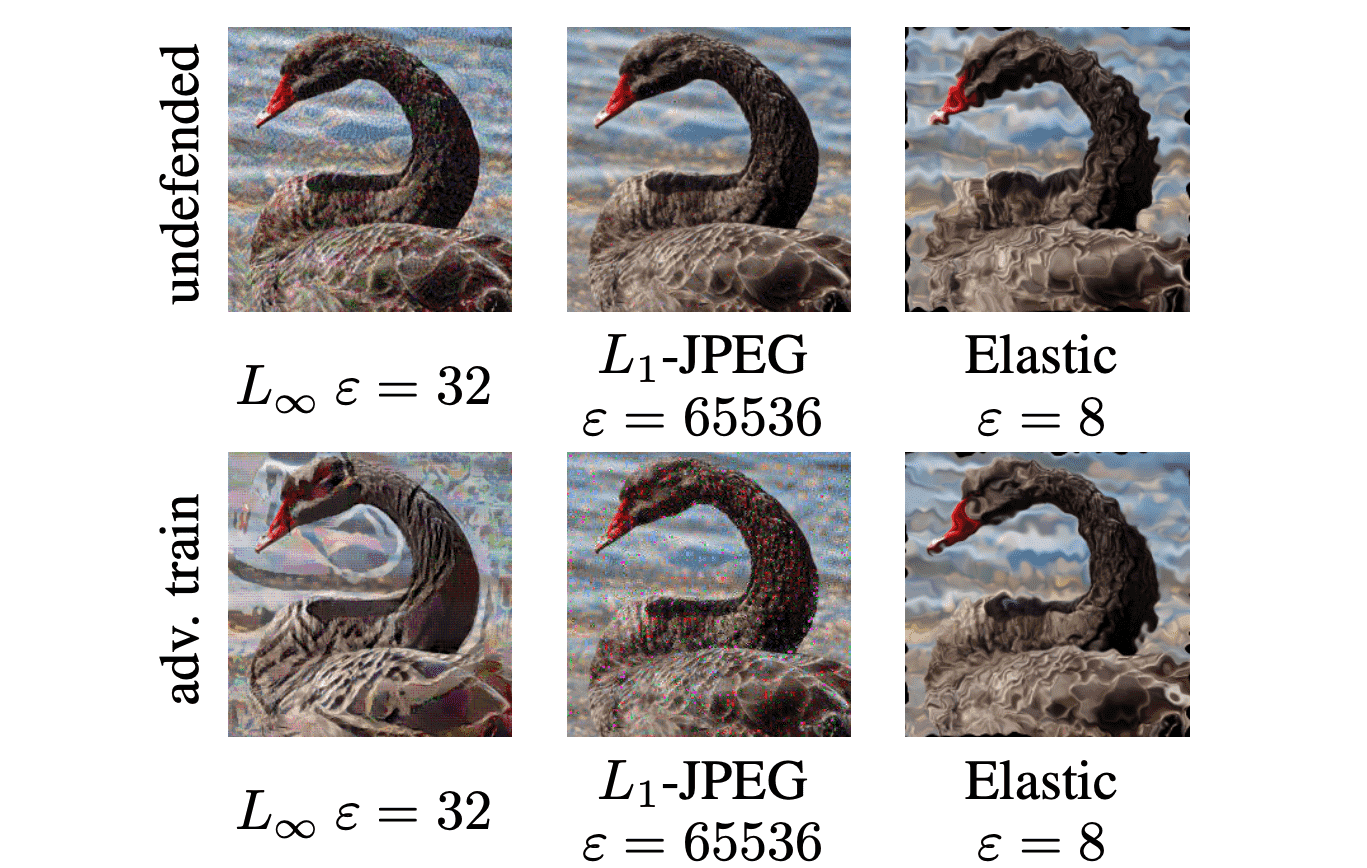

Современный нейронный сети выдают точные результаты для многих задач. Несмотря на это, такие модели чаще неустойчивы к искаженным изображениям. Например, L_∞ искажение отличается от оригинального изображения максимально на 32 по яркости пикселя. Человек может соотнести оригинальное изображение и искаженное, но стандартная нейросеть их различает.

Ранее нейросети проверялись на устойчивость на основе одного вида ранее неизвестного модели искажения. Это дает неполное представление об ограничениях генерализующей способности модели.

Суть UAR

UAR — это метрика устойчивости модели к состязательным атакам, на которых она не обучалась. Метод состоит из трех шагов. Оцениваются ранее неизвестные атаки, результаты сравниваются с защитной системой, в которой хранится информация о типе искажения.

Шаги включают в себя:

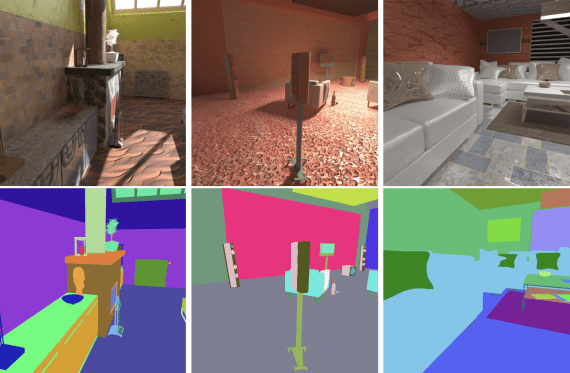

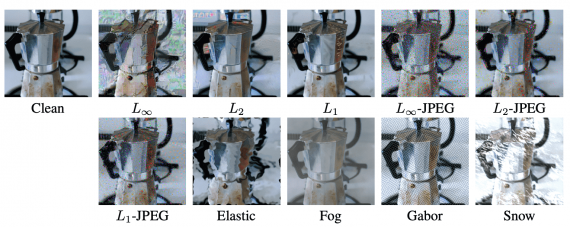

- Оценить модели на четырех разных типах искажений: L1, L2-JPEG, Elastic, Fog, — знания о том, как модель справляется с этими атаками, комплиментарны, потому что эти типы искажений друг от друга разительно отличаются;

- Выбрать широкий спектр силы искажений, который подбирается состязательно обученной моделью;

- Сравнить результаты, которые выдает модель, которая не обучалась на состязательных примерах, с той, что обучалась на состязательных примерах, — тут используется метрика UAR

Если метрика UAR близка к 100, это значит, что результаты модели на незнакомых состязательных атаках сравнимы с моделью, которая обучалась состязательно.