В последние годы большие языковые и диффузные модели продемонстрировали впечатляющие результаты, но их требовательность к вычислительным ресурсам и потребление памяти ставит перед исследователями и разработчиками серьезные вызовы. Курс TinyML & Efficient DL Computing, опубликованный на Youtube, это ценное руководство для специалистов и студентов, стремящихся оптимизировать использование ресурсов при работе с глубоким обучением.

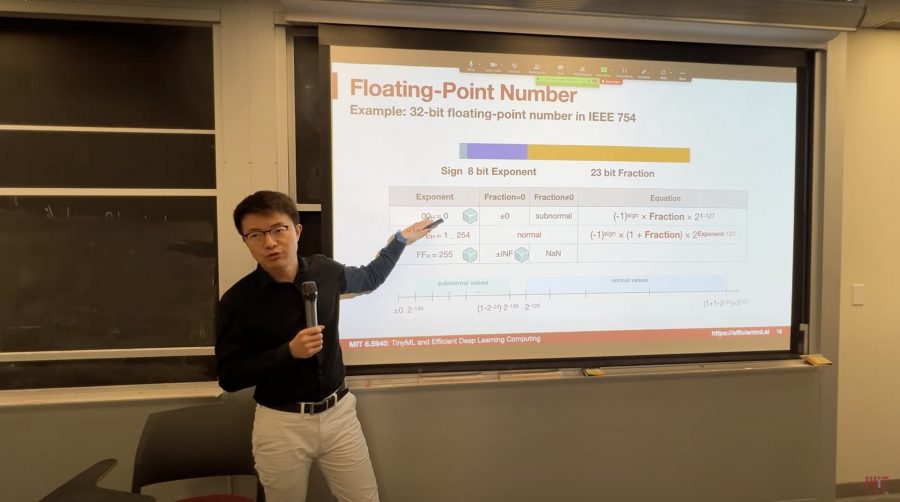

Основной акцент в этом курсе делается на разработке методов и техник, которые позволяют запускать глубокие нейронные сети на устройствах с ограниченными вычислительными возможностями. Преподают курс профессоры из MIT — Сон Хан, Хан Кай и Джи Лин. На выбор предлагаются как записи из аудитории, записанные в Zoom видео. Лекции выходят два раза в неделю по вторникам и четвергам.

На данный момент доступно 7 лекций:

- Введение — задачи, решаемые с помощью глубокого обучения;

- Основы нейронных сетей;

- Прунинг;

- Разреженность;

- Квантизация (часть 1);

- Квантизация (часть 2);

- Поиск оптимальной архитектуры с помощью нейросетей (Neural architecture search).

Основные темы, рассматриваемые в курсе, включают:

1. Сжатие моделей: метод позволяет значительно уменьшить размеры глубоких моделей, сохраняя при этом их производительность. Это особенно важно для использования на мобильных устройствах.

2. Обрезка: процесс устранения избыточных параметров в сети, что снижает требования к памяти и улучшает скорость обучения.

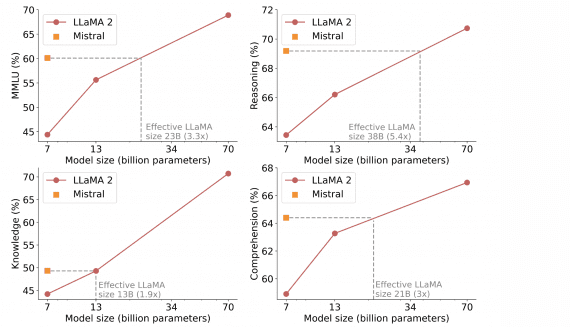

3. Квантование: уменьшение точности чисел весовых коэффициентов моделей, при котором достигается наименьшая потеря в точности модели, что экономит память.

4. Поиск нейронных архитектур: автоматизированный поиск оптимальных архитектур сетей для конкретных задач.

5. Распределенное обучение: эффективное использование вычислительных кластеров для ускорения процесса обучения.

6. Параллелизм данных/моделей: разделение данных и модели между несколькими устройствами для повышения производительности.

7. Сжатие градиента: методы сжатия информации о градиентах для уменьшения объема передаваемых данных.

8. Настройка на устройстве: адаптация модели к конкретному устройству для более эффективной работы.

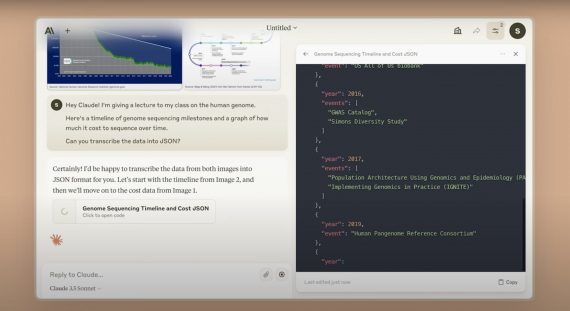

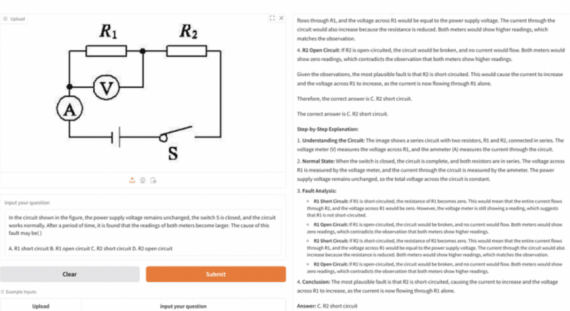

Курс также охватывает приложения этих методов в таких областях, как обработка естественного языка, распознавание видео и обработка облаков точек, что делает его необходимым для специалистов в различных областях.

Курс предоставляет студентам возможность получить практический опыт развертывания и использования больших генеративных моделей на ресурсоограниченных устройствах, что актуально в наше время, когда эффективное использование ресурсов становится все более важным в области глубокого обучения.