Google представила PaLM 2 – новую версию своей языковой модели, которая будет использоваться в более чем 25 продуктах и сервисах компании, таких как Bard, Workspace, Cloud, Security и Vertex AI. Обновление затронуло все аспекты разработки модели, включая использование более разнообразного обучающего датасета и оптимизацию вычислительной архитектуры.

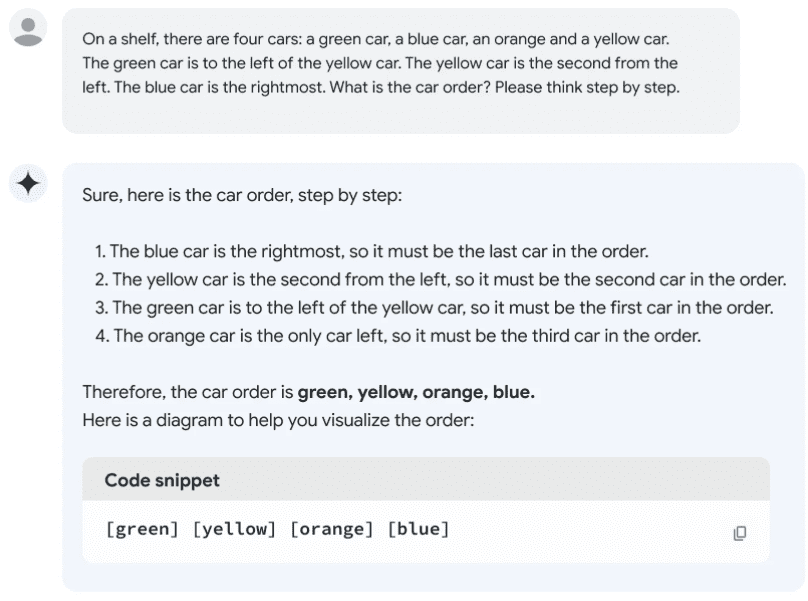

Нововведения увеличили производительность PaLM и расширили ее функциональность. Новая модель была обучена более чем 100 разговорным языкам и понимает двусмысленность фраз, переносные смыслы и идиомы. Улучшилась способность PaLM рассуждать, находить причинно-следственные связи и решать математические задачи. Для этого модель обучали на обширном корпусе научных публикаций и учебников по математике и физике. Пример ниже показывает, как новая модель решает логическую задачу:

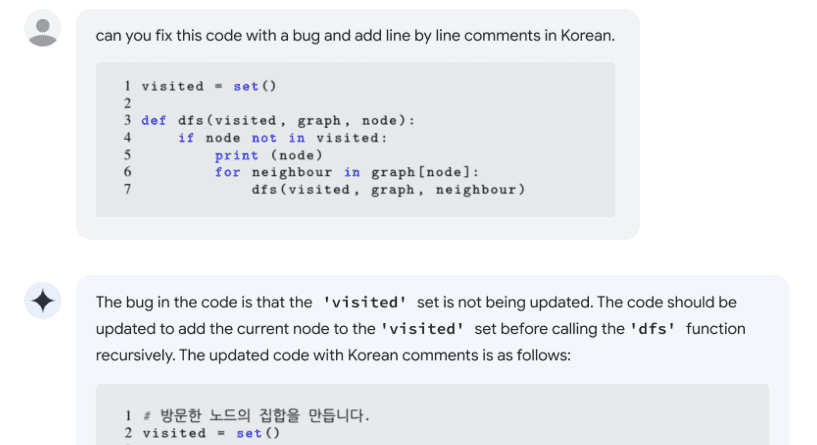

Расширены возможности модели по пониманию, генерации, документированию и отладке кода: PaLM 2 работает с более чем 20 языками программирования, включая такие старые языки, как Fortran.

Помимо базовой, Google планирует развивать серию второстепенных моделей, дообученных на специфичных определенному домену датасетах. Так, компания разработала модели Med-PaLM 2 для медицинских приложений языковых моделей и Sec-PaLM для обеспечения безопасности.

PaLM 2 была обучена на инфраструктуре, состоящей из тензорных ML-процессоров – собственной разработки компании. Google не раскрыла количество параметров новой версии модели. Первая версия модели обладала 540 миллиардами параметров.