Google представила PaLM – языковую модель с 540 миллиардами параметров. PaLM превзошла существующие языковые модели в большинстве бенчмарков.

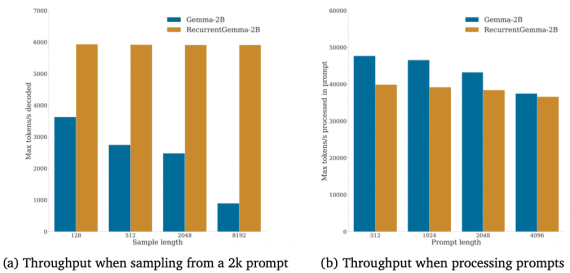

Модель обучена с использованием 6144 тензорных процессоров Google TPU на платформе параллельных вычислений Pathways. Данные для обучения включали комбинации английских и многоязычных датасетов с текстами сайтов, книг, статей Википедии, чатов и кодов с GitHub.

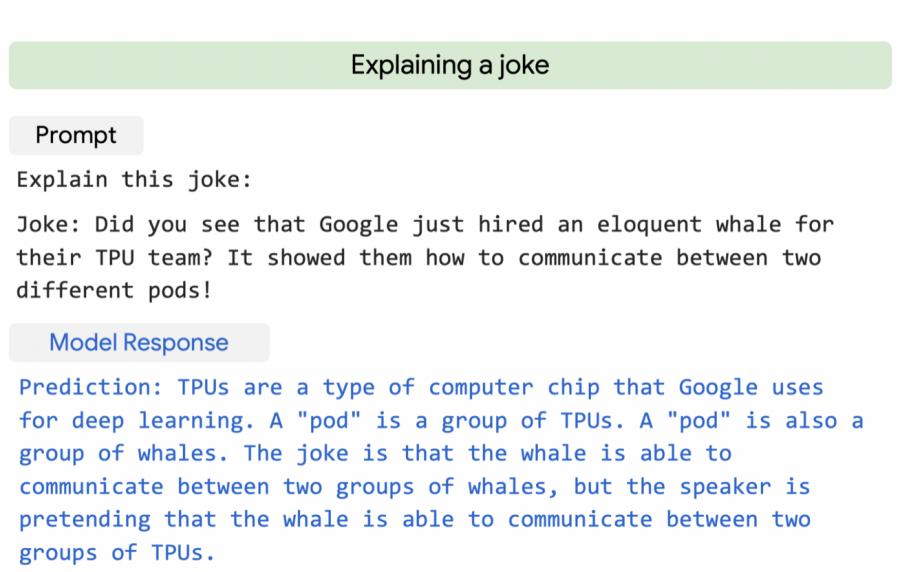

PaLM была проверена в нескольких сотнях задач по пониманию и генерации языка и показала превосходство в большинстве из них, причем во многих случаях – со значительным отрывом. Среди таких задач определение причин и следствий, понимание содержание, угадывание фильмов по эмодзи, поиск синонимов и контраргументов, перевод текста. В задачах ответы на вопросы и составления выводы точность PaLM превосходит state-of-the-art модели в несколько раз.

PaLM демонстрирует высокую точность при выполнении задач генерации кода несмотря на то, что в обучающих данных содержалось всего 5% кода. В частности, точность модели такая же, как у Codex, но при этом для обучения PaLM используется в 50 раз меньше кода на Python.