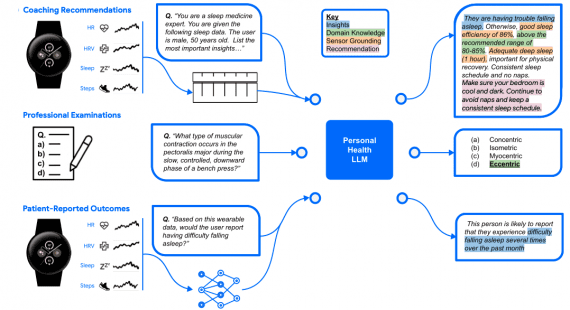

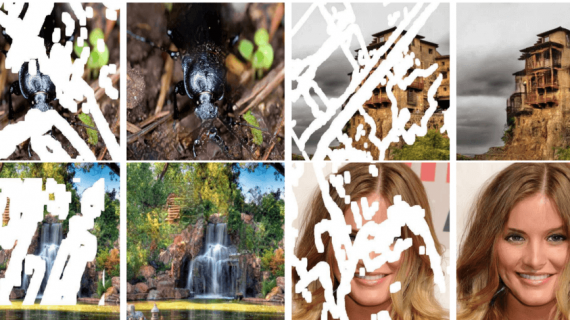

Нейросеть от Google AI симулирует движение камеры и параллакс для фотографий. Систему Cinematic photos используют в приложении Google Photos.

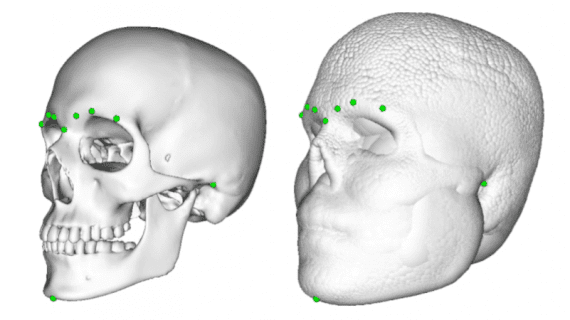

Оценка глубины изображения

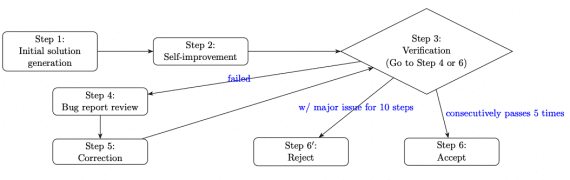

Наряду с такими последними функциями для фотографии, как Portrait Mode и Augmented Reality (AR), Cinematic photos требует карту глубины, чтобы иметь представление о 3D структуре сцены. В телефонах Pixel сцена захватывается с помощью двух камер или сенсоров с двумя пикселями. Это позволяет получить глубине сцены через разные точки обзора камер и известное расстояние между камерами. Чтобы Cinematic photos была доступна для фотографий, которые не были сняты на Pixel, разработчики обучили сверточную нейросеть с энкодер-декодер архитектурой. Нейросеть предсказывает карту глубины по одному RGB изображению. Маски сегментации для людей на изображении получают с помощью модели DeepLab, которую обучали на датасете Open Images.

Траектория камеры

Для реконструкции сцены в 3D, RGB изображение накладывается на карту глубины и получается сетка (mesh). Такой подход может приводить к наличию артефактов. Чтобы сделать систему устойчивой к артефактам, разработчики используют padded маски сегментации из модели оценки позы человека. Маски делятся на три части: голова, тело и задний фон.