Google PH-LLM: языковая модель для мониторинга здоровья

16 июня 2024

Google PH-LLM: языковая модель для мониторинга здоровья

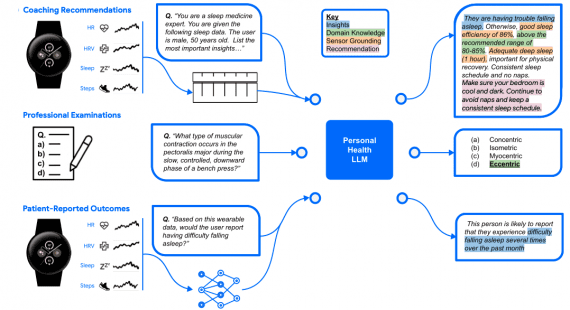

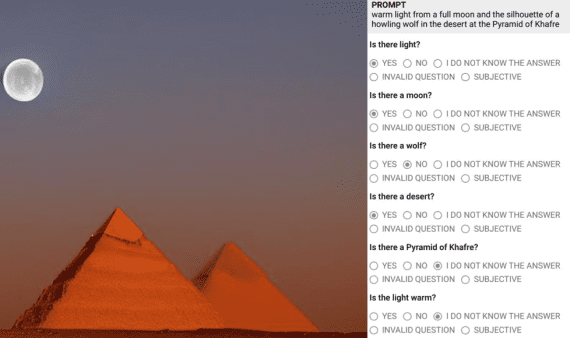

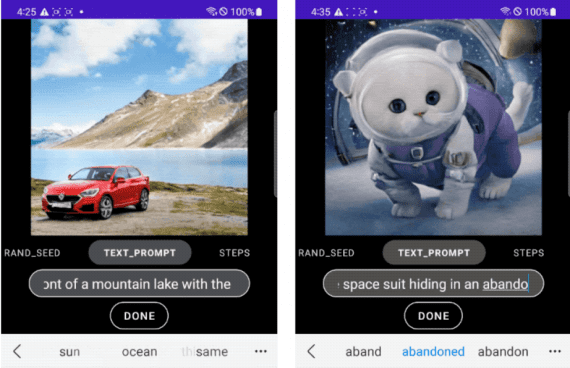

Google разработала языковую модель PH-LLM для анализа медицинских данных, собранных с носимых устройств – умных часов и пульсометров. В ходе экспериментов модель отвечала на вопросы о здоровье и прогнозировала состояние…