BART — это state-of-the-art нейросеть для суммаризации текстов. Задача абстрактивной суммаризации текстов предполагает, что модель получает на вход текст, а на выходе модель генерирует текст с описанием общих идей из входного текста. BART объединяет в себе двунаправленный энкодер из BERT и декодер из GPT-2. BART теперь доступен в библиотеке Transformers от HuggingFace.

BERT vs. GPT-2

BERT предобучается так, что бы предсказывать скрытые токены и использует всю входную последовательность, чтобы сгенерировать предсказание. Такой дизайн подходит, когда предсказание токена на позиции i позволяет использовать данные о токенах, которые следуют за i. Однако в задаче генерации текста предсказание может зависеть только от предшествующих токенов. За тем, какую информацию о входной последовательности использует модель, следит маска внимания (attention mask). В BERT используется полностью открытая (fully-visible) маска. Это значит, что модель может использовать информацию о всей входной последовательности при предсказании токена на позиции i.

В свою очередь, GPT-2 предобучается предсказывать следующее слово с помощью каузальной маски внимания. Архитектура GPT-2 больше подходит для генеративных задач. При этом модель менее эффективна, когда вся входная последовательность может использоваться для генерации выходного токена.

BART комбинирует в себе характеристики из BERT и GPT-2: энкодер из BERT, а декодер из GPT-2. Энкодер и декодер объединены с помощью кросс-внимания, где каждый слой декодера проходится с механизмом внимания по итоговому скрытому состоянию из выхода энкодера.

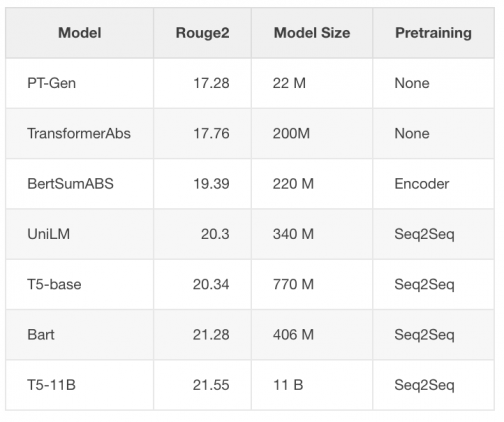

Задача суммаризации текста

Задача суммаризации текста заключается в том, чтобы модель сгенерировала текст с обобщенными идеями из входного текста. Seq2Seq могут быть напрямую подогнаны под эту задачу без дополнительных случайно инициализированных параметров.

I) Современный человек похож на слона в посудной лавке: мы меняем саму планету в планетарном масштабе. Для более точного описания качественно нового измерения роли человека в окружающей среде всё больше… Подробнее »